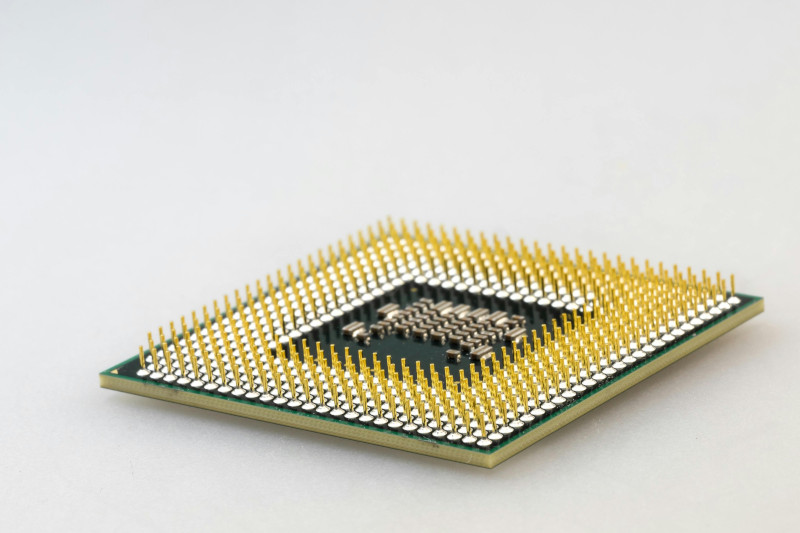

El procesador, también conocido como CPU (Central Processing Unit), es el cerebro del computador. Su función principal es ejecutar las instrucciones de los programas y coordinar todas las operaciones del sistema, desde abrir una aplicación hasta renderizar un video o ejecutar una simulación científica.

Cada avance en la tecnología de los procesadores ha marcado un salto en la potencia, la eficiencia y las posibilidades del mundo digital.

Los primeros procesadores: los años 40 y 50

En los inicios de la computación, los procesadores no eran chips como los de hoy, sino conjuntos de tubos de vacío y relés eléctricos que realizaban cálculos básicos.

Computadoras como la ENIAC (1946) usaban más de 17.000 tubos para procesar datos, y ocupaban habitaciones completas. Estas máquinas eran lentas, consumían enormes cantidades de energía y requerían mantenimiento constante.

El cambio llegó con la invención del transistor en 1947 y los circuitos integrados en los años 50, que permitieron miniaturizar los componentes y mejorar la velocidad de procesamiento.

El nacimiento del microprocesador: los años 70

En 1971, Intel presentó el Intel 4004, considerado el primer microprocesador comercial.

Este chip integraba 2.300 transistores y funcionaba a 740 kHz, un avance revolucionario para la época.

Poco después llegaron el Intel 8080 y el Zilog Z80, que impulsaron la primera generación de computadoras personales. Estas innovaciones marcaron el inicio de una carrera tecnológica que no se ha detenido desde entonces.

Los 80 y 90: el ascenso de los procesadores personales

Durante los años 80, Intel lanzó el 8086, base de la arquitectura x86, que se convirtió en el estándar de la industria.

A medida que avanzaban las décadas:

- Los procesadores comenzaron a incluir coprocesadores matemáticos.

- Se introdujo la ejecución en paralelo y la segmentación de instrucciones (pipeline).

- Aparecieron los procesadores RISC (Reduced Instruction Set Computer), con diseños más simples pero más rápidos.

En los 90, los usuarios empezaron a hablar de MHz, GHz y bits, mientras empresas como Intel, AMD, Motorola y IBM competían por ofrecer el procesador más rápido.

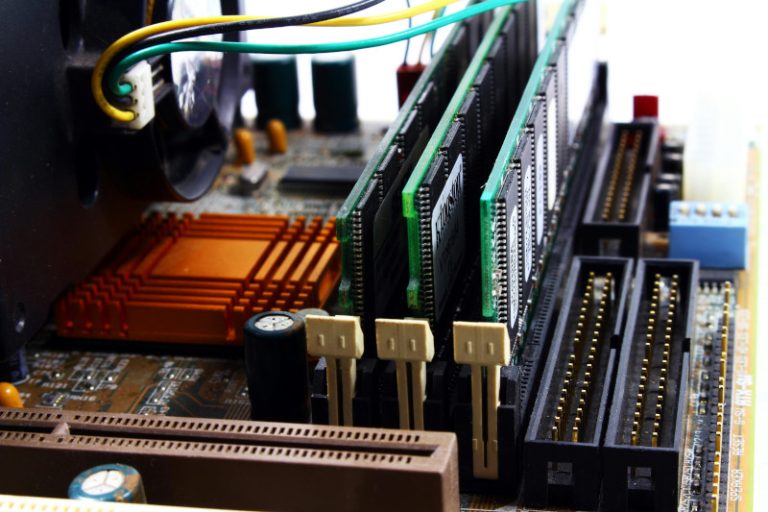

Los 2000: el salto a los multinúcleos

A comienzos del siglo XXI, el aumento de la frecuencia de reloj llegó a su límite físico por el calor y el consumo de energía.

La respuesta fue la arquitectura multinúcleo: varios procesadores trabajando en un solo chip.

Surgieron los Intel Core Duo, Core 2 Duo y luego las líneas Core i3, i5 e i7, junto con la expansión de AMD Athlon y Ryzen, que ofrecieron procesamiento paralelo y mayor eficiencia.

La era de los multinúcleos también impulsó la computación gráfica y científica, dando paso a los procesadores GPU para tareas masivas en paralelo.

La era moderna: inteligencia y eficiencia

Hoy en día, los procesadores combinan potencia bruta con inteligencia artificial y eficiencia energética.

Las principales tendencias actuales incluyen:

- Arquitecturas híbridas (P-cores y E-cores), como en los Intel Core Ultra y Apple M-series, que equilibran rendimiento y bajo consumo.

- Chips ARM, que dominan el mercado móvil y ahora compiten en laptops y servidores.

- Tecnología de 3 nanómetros, que permite incluir miles de millones de transistores en un chip minúsculo.

- Aceleradores de IA, integrados directamente en los procesadores para mejorar el aprendizaje automático y la computación predictiva.

El futuro de los procesadores

El futuro apunta hacia procesadores cuánticos y neuromórficos, inspirados en el funcionamiento del cerebro humano, capaces de procesar grandes volúmenes de datos de manera simultánea y con un consumo mínimo.

La meta ya no es solo aumentar la velocidad, sino repensar cómo se procesa la información, buscando máquinas más inteligentes, adaptables y sostenibles.